大型、超大型数据中心冷源架构设计若干问题

2018-08-06 来源:天下数据IDC资讯

导读

十台冷机并联的水系统会大到影响运行安全稳定性?

设计是为了限制运维?

什么是解耦型设计?

DDC能否适应未来复杂的自动控制系统/高级专家运维系统?

典型案例简介

某大型数据中心园区内有9栋数据中心楼,每栋设有可出租机柜6000柜,其中A1栋平均单柜密度6KVA,建筑面积约42000m2,共5层,1层为变配电及冷源辅助空间,2层整层及3层的一小半为银行等高等级客户,空调回风温度不高于26℃,平均功率为4kva;5层为互联网客户,平均功率为8kva;除2层外,服务器进风温度均不高于25℃。分层居中设置10kv变压器及ups设备。柴油机采用集装箱式,园区集中布设。冷源采用第四代智能冷源。

共设有10台高压变频离心机,其中3+1台1400RT冷冻水供回水温度12/18℃,5+1台1650RT冷冻水供回水温度18/26℃。

本案例纯属虚构,如有雷同,实属巧合。

冷源并联数量的影响

在前文《【研究】大型、超大型数据中心冷源架构设计若干问题》我们解释了以下几个疑惑:

水系统过于庞大,容易漏水。NO

水系统过于庞大,冷源流量难以平衡。NO

水系统过于庞大,水泵并联数量超过4台,存在运行隐患。NO

成文后私下有朋友交流中依然透露出,说的这么好,你有案例么?

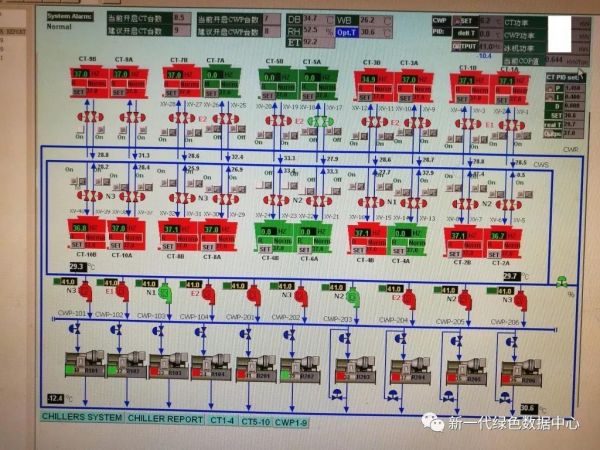

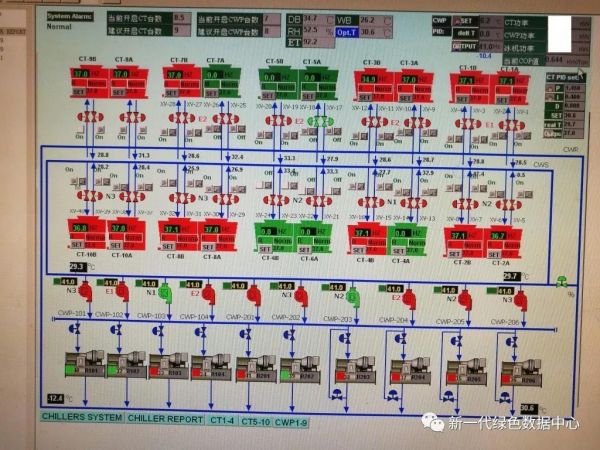

这是福哥近期参观的某全年不间断制冷应用场景下的项目,其不间断运行可靠性甚至高于数据中心,属于工业生产领域,一旦停机损失重大。

如果还纠结于是非数据中心,甚至是非金融业数据中心,我只能说竖子不足以谋。

什么叫难者不会,会者不难呢?这就是专业的力量,我们曾经在宝典中多次强调过,在数据中心基础设施领域,如果是非专业人员即使是简单到去启动或者关闭一个开关,仍然可能造成重大事故和损失。

在类数据中心行业(全年不间断制冷运行),还有很多甚至是20台机组并联的案例,后期有缘的话,再分享给大家。

冷源架构探索

仍然以上述参观案例为准,我们可以看到在实际运维中出现了开启冷却塔7台、冷取水泵8台、冷机7台。先不说其是否合理,但最起码将选择权交回到客户手中,而不是替客户做决定。

(当然我并不是反对替客户做决定,前提是要比客户更专业,数据中心领域由于仍属于少年时期,大多数设计院及设计人员的水平其实比拥有五年实际运营经验的甲方或者咨询顾问人员的水平要低很多很多,这个原因很简单前者还要把精力花在普通民用建筑/工业建筑上,而后者专门玩这个)

而常规设计中,我们很多经验不足的设计院及甲方,依然秉持着一对一的简单而落后的设计,先不说前文《【研究】大型、超大型数据中心冷源架构设计若干问题》提及的资源池化后,带来的资源可利用率和可靠性大幅提升的问题。

即使从简单的运维使用逻辑出发,池化的核心设备节点加上环网,既能实现一对一的简单逻辑,又能实现故障工况下的借用,还能实现专家工况下的解耦借用。

早在4年前,处在第一阵营的我们就应该已经明白,冷源系统中冷却塔、冷却水泵、冷机、板换是可以完全解耦的,而且在很多专家/高级管理/运行模式下,解耦之后不仅仅是可靠性和灵活性大大增加,而且会带来很大的经济效益,使得高效运行真正成为可能。

比如夏天高负载下,我们可以将备用塔的进出水管阀门打开,即使不调整水泵和冷机,我们能得到更低的冷却水出水温度或者更大的冷却水流量。(原因也很简单,我们更有效的利用了填料面积,减少了单个填料/冷塔的水侧阻力)

福哥最近将分享之前的研究,为什么我们把板换也应该解放出来。在水系统中,任何换热面积都应该被解放出来,原则是一样的,更大的换热面积能带来更大的换热量/更低的换热温差/更低的流体阻力。更大的换热量将能解决部分局部不平衡的问题;更低的换热温差,意味着更高的可接受源温度,更长的自然冷却时间;更低的流体阻力,意味着更低的流体传输功耗。

解耦型设计是不限制运维的设计,将最大的灵活性和高效性交回高效而专业的运维团队去实践和探索。在基础设施硬件层面将所有核心节点资源池化,通过环状网络互联,最终通过软件实现可选择的一对一或者一对多或者多对多等多种运行模式。当然带来这些好处的同时,解耦型设计对运维人员的能力也提出更苛刻更专业的要求,尤其是故障和意外场景下。

数据中心行业控制系统按照标准化采用DDC已经有很多年的历史了,但是大家普遍的感觉都是不如人意,甚至有一部分因为实施能力的问题,稳定性和可靠性成问题,而成为摆设。

之前数据中心领域内很多就地小的控制模块和单元其实就是PLC。

DDC属于部分固化的PLC,随着PLC工控领域的发展,其成本也显著降低。国内数据中心虽然已有数十年的历史,但本质上仍然是一个朝阳行业,每个项目因其终端客户,所处地理位置,运营管理团队能力,系统特点等而各有特色,而且全行业控制系统仍处在需求驱动阶段,项目控制系统需求的偏定制化属性较重,大范围采用PLC在未来一个周期内将是极大可能的趋势。直到新的标准化控制系统出现,DDC实现新的专家模式/高级管理运维模式的标准化,才会回到三十年河东。

胖子不是一口吃成的,罗马也不是一天建成的。现在的专业如果不能坚持持续学习,与时俱进,或许会变成以后的不专业。在未来,这些定制化的需求经历过实践考验,及大多数团队与能力跟上后,就会变成新的标准。而随着行业老去,或许设计和运维的力量对比会颠倒。那时买的没有卖的精,用的没有设计制造的厉害。但那已经是行业的黄昏,不再是需求驱动,而是产品驱动。

创新也一样,如果众人皆醉,你独醒。很有可能成为先烈而不是先知。

但这些都将是软件定义的基础设施必须要走的路,也是未来基础设施领域最可能大范围应用的技术。

未来的基础设施,简单的工作都将被机器人替代,无论是运行、建设还是设计。复杂一点的工作也不过是提供全范围动态数据交由专业工程师审核。大部分就像玩游戏一样,真正的高手不是找到了游戏的bug,而是通过专业能力敏感而直觉的找到了大数据覆盖下的直接而正确的逻辑。(智能机器需要通过大量的历史数据得出统计学关系,需要通过大量实时传感器和模糊神经试探性调节可调方向,观察能耗及能效统计结果而得出正确方向并逐步累加运行,而游戏高手可以直接根据专业能力直接得出新的调整值和调整方向)

标签: idc idc资讯 安全 大数据 服务器 互联网 金融 网络

版权申明:本站文章部分自网络,如有侵权,请联系:west999com@outlook.com

特别注意:本站所有转载文章言论不代表本站观点!

本站所提供的图片等素材,版权归原作者所有,如需使用,请与原作者联系。

上一篇:光学技术在数据中心中的应用与发展

下一篇:形形色色的集装箱数据中心