2019年深度学习的十大预测

2019-01-30 来源:raincent

2018年已经结束,现在是开始预测2019深度学习的时候了。以下是我之前对2017年和2018年的预测和回顾:

关于2017年预测和回顾。2017的预测涵盖了硬件加速,卷积神经网络(CNN)的主导地位,元学习,强化学习,对抗性学习,无监督学习,迁移学习,以及作为组成部分的深度学习(DL),设计模式和超越理论的实验。

关于2018年预测与回顾。2018年的预测涵盖了硬件初创公司,元学习取代SGD,生成模型,自我博弈,语义差距,可解释性,海量数据研究,教学环境,会话认知和人工智能伦理。

通过回顾我的预测表明,我发现我太乐观了,高估了技术发展的速度。总的来说,社区一直处于一种夸大的期望状态。事后看来,是因为忽略了一般认知的潜在复杂性。我们现在必须降低期望,并专注于有希望的领域。这些有希望的领域将逐步取得进展而不是“moon shots”(注:一个疯狂的想法或者不大可能实现的项目)。

革命性进展应该分阶段发生,我们今天遇到的是实现Interventional level的主要障碍。这并不意味着我们不能取得任何进展,而是在目前的成熟度水平中有许多悬而未决的成果,而这些成果已经准备好进行开发,DL在2019年的进展将主要围绕这一务实的认识。

以下是我的预测,与前几年一样,它们可作为跟踪DL进度的指南。

1. 深度学习硬件加速减缓

深度学习硬件加速已经减缓,脉动阵列在2017年给全世界带来了巨大的加速增长。我们不能指望2019年计算能力的大幅提升,NVidia的图灵核心只比Volta核心快一点。谷歌的TPUv3系统现在采用液冷,与之前的产品相比,密度更高。我不认为2019年会有任何重大的架构改进,因此不要像往年那样大幅增加。

但是,我们将看到GraphCore和Gyrfalcon的新架构规避了内存传输的功率成本并支持稀疏操作,但是需要更改深度学习格式来适应这些新架构,以及需要进行新的硬件研究,这个灵感来自生物学的纳米意向性。

2.无监督学习已经解决,但不是所预期的

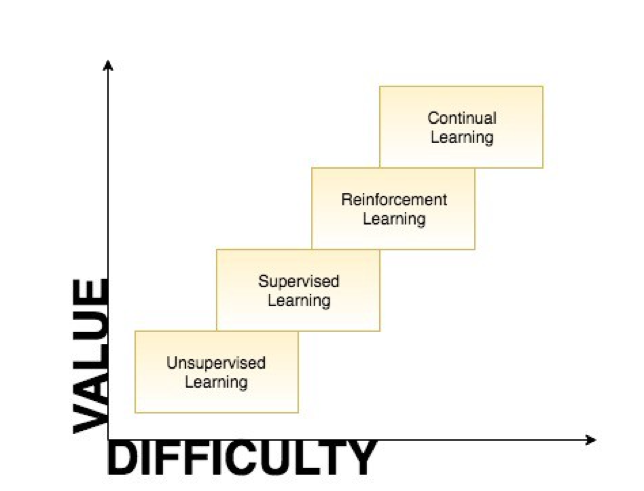

无监督学习的思维方式都是错误的。LeCun的蛋糕理论是错的,不同类型的学习关系应如下所示:

为什么UL价值最低,难度最小?那是因为没有目标,你可以做任何可能有效或无效的集群。最终,它归结为基于UL嵌入的更高层的性能。UL嵌入本质上是包含丰富的先验数据,这些先验如何被利用取决于具有目标的上游过程。ELMO和BERT已经发现我们可以训练用来预测(或生成)其数据的UL,这是上游任务的良好基础。UL基本上是监督学习,其标签已存在于数据中。简而言之,UL已经被解决了,但并没有像大多数从业者所期望的那样。如果网络可以做出良好的预测或者可以生成原始数据的良好传真,那么这就是UL。

因此,每个人都认为解决UL将是一项重大进展,因为人们可以使用没有人类标签的数据。不幸的是,因为免费提供的东西很容易提取,它已经被解决了。我在2019年对UL的预测是,研究人员将接受这一新观点,转而关注更有价值的研究(即continual或interventional学习)。

3.元学习仅适用于研究

我们对元学习的理解似乎与对无监督学习的理解一样模糊。如今所实践的元学习更像是迁移学习。实际上更高级的元学习可以构建和改进自己的模型的。元学习应该能够建立外推和创造性的学习模型,但我们无法实现这一能力。

任何适用于多领域的学习方法在技术上都是元学习算法。例如,梯度下降、遗传算法、自我博弈和进化都是元学习算法。元学习方法的目标是开发在许多领域中学习良好的算法。

目前很少存在已知的元学习算法,但是知道存在一种我们不理解的元学习算法,我们不了解人们使用的元学习算法。此外,元学习像无监督学习一样是一个太普遍的问题,以致无法理解如何以通用的方式解决,可能天下真的没有免费的午餐。

我认为有些具体的方法(如生成模型,混合模型和课程训练)将有更好的机会获得更有价值的结果,这意味着我们发现的元学习算法仅对特定类型的学习任务有用。就像通过梯度下降学习只为特定任务加速梯度下降一样,元学习只能改善它所见过的任务中的学习。简而言之,元学习充其量是内插的,不能概括全部,也许不存在通用的元学习方法,而存在一套元学习方法,可以拼凑在一起来产生有效的课程。

总之,元学习仍将需要研究。

4.在科学中的应用生成计算模型

我们将可以更好地控制生成模型。这里有三类已被证明是有效的生成模型:变分自编码器、GAN和基于流的生成模型。我希望看到GAN和Flow模型的快速发展以及VAE的进展。我还期望在科学探索中看到这种涉及复杂的自适应系统应用(即天气、流体模拟、化学和生物学)。这方面的进步将对科学进步产生深远的影响。

5.混合模型在预测中的应用

深度学习在提供高维系统预测方面发挥出优势。然而,深度学习仍然无法制定自己的抽象模型,这仍然是解释性和外推预测的基本障碍。为了补充这些限制,我们将看到混合双重过程解决方案,它将现有模型与无模型学习相结合。

我觉得使用hand-crafted的模型可以减轻无模型RL的低效率问题。我期待关系图网络的进展,并且当这些图与先前的基于模型的模型有偏差时,我们会看到令人印象深刻的结果。我还期望通过融合现有的符号算法与DL,来提升预测能力。

DL的产业化将不是因为我们在迁移学习方面取得了进步,而是通过人工模型和DL训练模型的融合。

6.更多模仿学习方法

模仿不需要外推推理,因此我们将会看到在模仿各种现有系统方面取得的相当大的进展。为了能够模仿行为,机器只需要创建一个反映行为的描述性模型。 这比生成建模更容易,因为生成建模必须要发现未知的生成约束。生成模型运作良好的原因是它所做的只是模仿数据而不是推断生成数据的潜在因果的模型。

7.更多深度学习集成设计探索

我们将看到许多生成模型的研究转移到现有的设计工具中。它首先出现在视觉领域,并逐步向其它方向发展。

事实上,我们甚至可以将AlphaGo和AlphaZero的进展视为设计探索。竞争性围棋和国际象棋选手已经开始研究从DeepMind游戏AI引入的探索策略,来开发以前未被探索过的新策略。

深度学习方法的简单匹配算法和可扩展性将成为可以改善人类所完成设计的头脑风暴机器,许多深度学习方法现在都集成在Adobe和AutoDesk的产品中。 Style2Paints是与标准桌面应用程序集成的深度学习方法的绝佳示例。

深度学习网络可以降低人们在工作流中完成任务所需的认知负荷。深度学习允许创建擅长处理更模糊和更混乱的认知细节的工具。这些都需要减少信息过载,提高召回率,提取文本和更快的决策。

8.端到端训练的衰减,未来会注重发展性学习

端到端训练的回报将会减少,我们将看到在不同环境中训练的网络来学习专业技能,将这些方法拼接在一起形成的新方法,来作为更复杂技能的构建块。我期望在2019年看到课程训练的进步以及希望看到更多的研究受到人类婴儿发展的启发。训练网络执行复杂的任务将涉及复杂的奖励设置,因此我们需要改进方法来解决这个问题。

9.更丰富的自然语言处理嵌入

NLP已经在2018年取得了进展,这主要归功于创建词嵌入无监督学习方法的进步,2018年NLP的进展可归功于更先进的神经嵌入(ELMO,BERT)。通过简单地替换更丰富的嵌入,这些嵌入改进了许多上游NLP任务,关系图网络中的工作可以进一步增强深度学习NLP功能。

Transformer网络被证明在NLP中非常有价值,我希望它在其他领域继续采用。我认为ConvNet网络的主导地位将受到Transformer网络的挑战。我的直觉是,与ConvNets可用的固定机制相比,注意力是一种更加通用的机制,用于实施不变性或协方差。

10.采用控制论和系统思维方法

深度学习实践的一个主要缺点是缺乏对大局的理解。我们正处在需要从更多非传统来源获取灵感的时刻,我相信这些来源是以前控制论及其相关的系统思维学科的研究。我们需要开始考虑如何构建强大的智能基础架构和智能扩充。这需要超越目前许多研究人员的机器学习思维。

迈克尔在他的文章“人工智能 - 革命尚未发生”中评论说,诺伯特维纳的控制论已经“主宰当前时代”。控制论和系统思维将帮助我们开发更全面的方法来设计AI系统,成功的人工智能部署最终将与他们如何与人类用户的需求保持一致。这将需要探索和制定整合各种相互作用部分的整体方法。

许多更新颖的深度学习方法可以追溯到控制论中的思想。对自主AI需要在其世界模型中包含主观视角的理解将会增加。预测编码、由内到外的体系结构、体现学习、及时推理、内在动机、好奇心、自我模型和可操作的表示都在这个范例中相关。

总结

深度学习继续以突破性的速度取得进展,我希望研究可以转变为工业应用。在当今市场中理解深度学习的普遍缺点是无法为现有问题制定整体解决方案。创建将DL作为一个组件整合到整体中的解决方案的能力将是一种追求的技能。机器学习方法论可能是错误的,我们可以在控制论中可以找到更合适的观点。我们可能无法在短期内实现AGI,但深度学习可用的工具和方法可作为科学和商业中有价值应用的坚实基础。

文章原标题《10-predictions-for-deep-learning-in-2019》

译者:乌拉乌拉

版权申明:本站文章部分自网络,如有侵权,请联系:west999com@outlook.com

特别注意:本站所有转载文章言论不代表本站观点!

本站所提供的图片等素材,版权归原作者所有,如需使用,请与原作者联系。