“灰盒”模式构建数据中心光层互联

2019-12-10 来源:天下数据IDC资讯

随着大数据时代的到来,以及人工智能、虚拟/增强现实、物联网等新型技术的出现,数据流量呈现爆发式增长。据Cisco预测,到2021年,全球数据中心的IP流量将会增长至20.6ZB,而99%的网络流量都与数据中心有关。可见互联网业务对数据中心的依赖程度越来越高,而且数据中心的流量也不再仅限于南北向流量,数据中心之间的同步、灾备、虚拟机迁移,以及数据中心云化、并行计算等新需求的出现,使数据中心东西向流量迅速增加,未来数据中心的东西向流量和占比还会持续增加,可能会占到80%以上。

数据中心互联成为迫切需求

互联网流量特别是跨数据中心的流量增长,使数据中心互联成为迫切需求,而且大带宽的互联需求也会增多。从电信运营商数据中心互联的情况来看,目前对于城域网范围可以基于传输专线提供独占带宽的DCI服务,也可以利用163/IP城域网提供共享带宽的DCI服务;对于跨骨干的DCI服务或与天翼云的连接,则通过延伸交换机连接到骨干DCI/CN2,底层采用波分系统承载需求。

对于城域范围的数据中心互联,上述方式目前可以满足几Mbit/s到100Gbit/s的带宽需求,但运营商一般对于构建DC互联网络的驱动力不足,主要是在客户提出需求时,根据客户的需求来提供相应的传输专线服务,如MSTP、OTN,对于需求不高或考虑经济因素的中小企业客户也可能采用MPLS VPN的方式来提供DCI服务。当DC互联的需求流量不大时,开通专线的方式可以满足需求,但是考虑到大带宽流量需求,运营商也正在考虑成本更低的方式来满足业务承载。

与电信运营商不同的是,在数据中心光互联方面,大型互联网厂商处于领跑地位。由于DC东西向流量需求的驱动,很多大型互联网选择租用裸纤,采用自建波分系统的方式来满足100G以上甚至T级别的DC互联需求。在这种需求场景中,由于主要是点到点互联,设备资源无法共享,所以成本较为敏感,并且希望可以按需快速部署;考虑到数据中心机房的机柜尺寸、通风散热方式、供电方式等特点,对设备外观和尺寸的要求也异于传统波分设备;除此之外,也会对波分系统的管控提出要求,包括光、电层设备硬件参数的配置,性能数据的上报和分析、告警信息的获取等。如何构建低成本的、适用于DC互联场景的波分系统,同时为其提供灵活的管控能力,是值得探索的问题。

开放与分解的光网络来破局

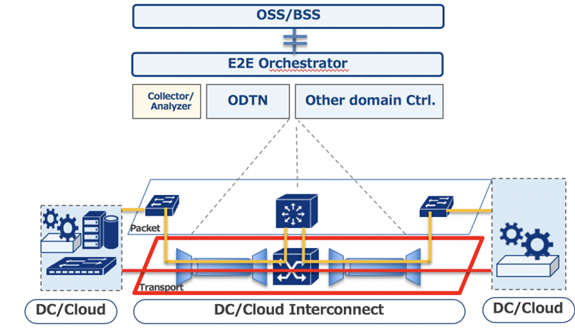

构建开放与分解的波分网络,来实现数据中心的光层互联,可能是解决上述问题的较好思路。2018年,ONF成立了ODTN(Open Disaggregated Transport Network)项目,该项目由运营商主导,旨在利用光电解耦的设备、开放且通用的标准和开源的软件来构建数据中心互联。ODTN项目希望分解网络组件并提供开源软件来控制多厂商设备,供应商可以专注于特定的组件而不必构建完整的解决方案,达到加快创新和降低成本的目的,同时允许运营商自由选择同类的最优组件,规避供应商锁定的问题。图1为ODTN的系统架构图。

图1 ODTN系统架构图

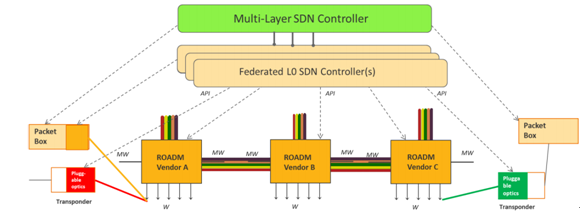

除ODTN以外,Facebook主导了致力于光和IP网络中开放技术的OOPT(Open Optical & Packet Transport) 项目 ,AT&T主导OpenROADM项目并定义了开放、分解的ROADM系统及相关的业务、网络模型、设备和数据模型,图2为OpenROADM的系统架构图。

图2 OpenROADM系统架构图

开放是纵向的解耦

开放是纵向的、控制平面和数据平面的解耦,可以引入SDN理念实现光网络管控,达到软件开放源码、接口规范标准、数据模型统一、控制转发分离和网络能力开放的目的。纵向的开放使SDN理念得以引入光网络,同时也推动了设备的白盒化,因此可认为白盒化与SDN是相伴相生的。

在传统模式下,厂商设备以黑盒的方式提供,是完全封闭的,由设备厂商提供设备,并由厂商私有网管控制设备,实现功能配置;接口私有化,设备的软硬件更新迭代依赖于主流设备厂商的研发能力和市场策略。

而在完全开放实现SDN管控的情况下,设备可以由设备厂商或光器件厂商提供,设备内部的光器件、模块均可以通过统一接口被纳管,控制粒度更细,需要针对主要器件的物理参数建立信息模型,并制定业界统一的接口规范,技术迭代也会更快。

传统方式已经受到挑战,而完全开放的SDN管控目前还不具备条件,从实现设备商开放能力和运营商管控需求两者匹配的角度而言,“灰盒”可能是目前的最佳选择,即能力“部分开放”,由设备厂商提供设备,并按标准化接口开放能力,允许跨厂商统一纳管。

分解是横向的解耦

分解是横向的、数据平面硬件之间的解耦,它可以达到硬件通用化和降低成本的目的,同时也可以避免厂商锁定。根据分解程度的不同,可以分为部分分解和完全分解两种方式:将电层的终端设备和光层的线路系统分解是部分分解;将网络中的各个功能模块均分解为独立的设备被称之为完全分解。

从目前的商用情况来看,主要还是以部分分解为主,即实现了光层与电层的解耦。比起完全分解的方式,部分分解的方式难度相对较小,目前阶段可以作为传输系统分解的一种推荐方式,但是也需要解决诸如性能评估和运维管控等问题。从开放管控的角度来看,这种部分分解的设备形态,其实就是灰盒模式,所以无论从开放还是分解的角度来看,部分分解的灰盒模式更有利于商业化推动。

分解可以带来设备形态上的变化,使机架和设备完全解耦,允许设备容量按需配置。另外,传统通信机房的制冷系统能耗占比已经超过设备的能耗占比,在散热架构和冷却手段的应用上都落后于数据中心。

而且,分解后的设备可设计为刀片式,这种方式风道简单、阻力小、能耗低、噪声小,能够更好地适应各种先进的数据中心冷却方案,同时供电方式也由直流改为交流,更好地适应数据中心机房的供电。此外,将光模块从板卡中分解出来,采用可插拔的方式设计,也属于分解的一种,它可以驱动模块厂商专注于模块研发,减小模块体积、降低模块功耗,而设备厂商也可以减少整体研发投入,提升板卡集成度,降低板卡功耗。

运营商面临机遇与挑战

由于需求驱动的原因,率先致力于推动利用开放与分解的波分系统来构建数据中心互联网络的主要是大型的互联网公司如腾讯、阿里等,尽管没有公开数据,但可以预见未来加大投入的互联网公司会越来越多,这种技术方案的开放、分解特性也使得更多光器件厂商、传输设备厂商直接参与进来。在此趋势下,运营商也在积极开展相关设备和管控系统的测试与研究工作。

在互联网流量持续增长的背景下,越来越多的互联网公司会面临TB/s级别的高速率数据中心互联需求,波分系统的引入将成为未来数据中心互联场景中的主要技术选择。很多大型互联网厂商在需求驱动下已经开始着手自建波分系统,且出于打破厂商锁定、降低建设成本、利于快速迭代、强化网络管控等多方面考虑,倾向于选择开放与分解的方式构建光网络,与芯片、器件厂商深度合作,实现光电解耦,多厂商统一管控。

这对于运营商来说是机遇也是挑战。运营商在网络领域有较为丰富的规划建设和运营维护经验,面对客户带来的迫切的大带宽需求,可以考虑针对数据中心互联场景建设专用的波分传输系统。数据中心互联波分系统建设的技术方案可以借鉴互联网企业和国外运营商在光网络开放和解耦方面的经验,结合电信运营商自身在网络领域的建设和运维方面的优势,向着灵活解构、全面管控的数据中心互联光网络演进。

开放必定会带来灵活性,分解必定会降低成本,利用开放与分解的光网络来构建数据中心光层互联,会成为业内越来越受关注的技术方向。

【凡本网注明来源非中国IDC圈的作品,均转载自其它媒体,目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。】

延伸阅读:

- 浙江电信以DC组网为核心的5GC云化实践部署

- SDN完美契合云数据中心发展路径

- 运营商如何找到5G需求的新商业模式

版权申明:本站文章部分自网络,如有侵权,请联系:west999com@outlook.com

特别注意:本站所有转载文章言论不代表本站观点!

本站所提供的图片等素材,版权归原作者所有,如需使用,请与原作者联系。