A5虫虫营销助手9月3日售后群分享:文章采集与网…

2011-09-05 18:49:23来源:未知 阅读 ()

A5虫虫营销助手售后群有很多高手。为了让各位学到更多东西,我们定期组织交流分享活动,把分享氛围带动起来,把高手的经验挖掘出来,帮助各位建立人脉,更加快速的进步。我们致力于把虫虫售后群打造成互联网网站/营销高手群。在这里,你学到的不仅是关于虫软。

以后不出意外,我们每周六晚8:30会举办分享活动,欢迎各位准时参加,也欢迎各位联系我,把你的心得分享给大家(暂时分享人奖励t恤一件,以后奖品会增加),售后群目几百多人,每人都能分享一点点的有价值的心得,这个意义就非常大。分享创造价值。今天分享人是乐逍遥与二十二,给各位带来关于主题“文章采集与网址抓取”的一些常用方法与技巧。

乐逍遥——文章的采集:

文章采集的第一部分是列表页面地址的填写,这个实际就是1个正则,虫虫是正则采集的,实际很简单,[page]变量代表页码,page数字

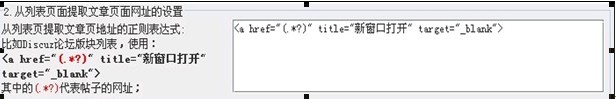

这个大家基本都知道,这里也是比较容易配置的。一般就是一行链接代码,把其中的href链接网址部分,用(.*?)代替即可。虫虫软件采集规则适用的都是标准的正则表达式写法,前后的括弧表示这是提取出来的一个参数。其实不一定是(.*?),其它的写法例如([^"]*)也是可以的。

这个就是说 (.*?)代替了地址,(.*?)这个正则就是替代了地址而已,很简单,也很好理解。

第3部分,文章标题和正文的提取,这部分是最难的。其实也不难,就是找出标题前后的特征,正文前后的特征,然后组合起来就是了。标题一般情况下都是可以用(.*?)代替,这个正则表达式的意思是在同一行上,匹配所有字符(不包括换行符),除了碰到他后面的字符串了。正文一般情况下都可以用([\s\S]*?)来代替,这个表达式的意思是匹配所有字符(包括换行的,因为正文里面有可能包括换行符号),除了碰到他后面的字符串了。加了括弧的正则表达式,代表作为参数要提取出来使用,如果源代码里面标题在前面,就选“标题在前”,否则就选“标题在后”。这里只允许2个加括弧的正则表达式,其它部分也可以存在正则表达式,但是不需要提取出来使用,也就不能加括弧了。加至于正文和标题中间,一般都可能有很多无关代码内容,统一可以用[\s\S]*代替,这个是不加括弧的。无关代码内容,统一可以用[\s\S]*代替,这个是要注意的,正文一般情况下都可以用([\s\S]*?)来代替,基本搞清楚 这2个就OK。

例如我们采集http://www.chongseo.com/news/ 这个栏目下的文章,可以这样写第一部分:http://www.chongseo.com/news/list_2_[page].html,然后再把网址给找出来,<a href="/news/20110825/109.html">chongseo教您网站提高流量10大技巧</a><li><span>,<a href="/news/20110825/109.html">,正文一般情况下都可以用([\s\S]*?)来代替,然后开始测试采集,OK,成功。

二十二——基本参数与网址抓取:

1、基本参数:

A大项,线程,大家应该都能明白,并不是越快越好,要视情况而定,例如在注册的时候可以选择30-50线程,但在做博客群发还有问答类群发时用1个线程。

B大项,重点就是一个自定义邮箱设置,这个反应的问题比较多,我说一点,新注册的邮箱不一就直接用pop功能,一定要先登陆邮箱看看有没有开通,开通之后再设置,这样就不会有错了。

C大项需要注意的时候,注册的用户名,记住是8---12位,今天有人群里截图问什么会出错,长度太长了,没有注意。

D大项,没有什么好讲的,大家进来在群里提问没有关于这方面,我就不多讲了,直接说抓取。

2、网址抓取 明白;第二,验证程序,就是你要抓取目标网站的类型,目前虫虫增加了一个自动验证,通常大家选择这个就很不错;服务器类型的选择 一个GG,一个bd,一个yh。

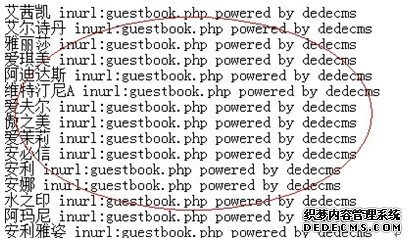

bd资源跟yh的资源相对较少,GG一般来说抓取的量是非常大的,一般情况40条左右规则抓取1万以上是没有任何问题,抓取靠的就是就搜索指令,虫虫自带了很多条搜索指令,当然自己也可以分析目前主流CMS程序情况来写规则,如DZ论坛程序,intitle:Powered by Discuz!,这条规则是百度与GG都可以使用的抓取DZ论坛的。你在绑定验证程序时选择自动验证,这样不管是DZ NT,还有DZ1.5-2.0都可以选出来。

那怎么样大量抓取呢,当然一条规则肯定是不行,我们来看这个,北京 powered by Discuz! X1.5 inurl:forum.php,这条搜索指令就是显示出有北京当地所有的DZ1.5论坛。百度只能抓取前7页,而GG能抓取N页,但在GG抓取的时候一定要用国外的IP进行抓取(这点大家应该都明白,天朝)所以我建议大家如果想大量抓取网址,花10多块钱买个VPN包月,那这样一月下来,百万条网址不是问题。像刚才讲的北京powered by Discuz! X1.5 inurl:forum.php,这里的北京关键词都在哪里找,我教大家一个方法,去各大输入法网站去下载词库。当然,我们下载了,不可能一条条增加进去,要批量导入指令。首先我们先将下载好的词复制到excel中,进行处理下。A列复制关键词,B例放规则。然后将这两例全选复制到txt文本,再进行下空格替换,替找内容为大概5个空格左右,替换为一个空格,那么最终处理结果就是这样的。

自由团:那么里关键字不用理吗?

答:可以不用理,批量导入的时候前面已经加上关键字了,而且是大量的,比在这里加的要强,如果你要单一搜索一个关键字话,可以。

自由团:化妆品 powered by Discuz! X1.5 inurl:forum.php,例如我是要找化妆品的网站,是不是这样的规则?

答:是跟化妆品有相关的网站都会出来,当然也有不相关的也会出来。

.﹎平凡:能讲些关于英文的网址抓取采集方面吗?谢谢!

答:英文方面我没有涉及过,只做百度,可以给你提供一个方法!虫虫带的有英文网址的抓取,你可以自已去分析下各大英文论坛是什么样的网址形态来抓取,最简单的办法就是查你竞争对手的网站外链,虫虫有这条规则,也很有用,也很实用。

标签:

版权申明:本站文章部分自网络,如有侵权,请联系:west999com@outlook.com

特别注意:本站所有转载文章言论不代表本站观点,本站所提供的摄影照片,插画,设计作品,如需使用,请与原作者联系,版权归原作者所有

上一篇:百度联盟峰会一票难求

- 使用侠客站群系统高级版的体会 2012-04-24

- 网站内链锚文本重要性 您忽略了吗! 2012-04-24

- 送给还在手工做站纯真的孩纸们 2012-03-19

- 一周内如何快速提高百度权重 2012-03-19

- 我的侠客站群盈利计划,来试试吧 2012-03-15

IDC资讯: 主机资讯 注册资讯 托管资讯 vps资讯 网站建设

网站运营: 建站经验 策划盈利 搜索优化 网站推广 免费资源

网络编程: Asp.Net编程 Asp编程 Php编程 Xml编程 Access Mssql Mysql 其它

服务器技术: Web服务器 Ftp服务器 Mail服务器 Dns服务器 安全防护

软件技巧: 其它软件 Word Excel Powerpoint Ghost Vista QQ空间 QQ FlashGet 迅雷

网页制作: FrontPages Dreamweaver Javascript css photoshop fireworks Flash